Synology DS220+

In den Jahren 2011 und 2013 hat sich jeweils einiges an der heimischen IT-Infrastruktur - im Heimnetz - getan. 2011 habe ich - mehrere Jahre nach dem Umzug - in unserer neuen Wohnung einen Server eingerichtet und die alte Maschine an anderem Orte in den Ruhestand geschickt; außerdem habe ich die gesammelten Daten von primär einem, letztlich aber mehreren alten Rechner gesammelt auf meinen aktuellen Desktoprechner übertragen und eine aktuelle Version meines damaligen (und jetzigen) Mail- und Newsreaders installiert. 2013 kamen ein Multifunktionsgerät (Drucker/Scanner/Fax) und ein NAS - eine DiskStation von Synology - hinzu (und ein neuer Desktop, der Vorgänger meines aktuellen Geräts).

Überraschend viel davon ist geblieben: der nunmehr mehr als 11 Jahre alte Homeserver, für den schon ein Ersatz bereitsteht, den ich irgendwann einmal einrichten müsste; die Datenstruktur auf meinem Desktoprechner und Agent als News- und Mailclient; bis vor zwei Jahren der Drucker; und auch das NAS. Im Prinzip war ich mit letzterem und meinem Backupkonzept auch ganz zufrieden; 2017 hatte ich nach einem (mutmaßlichen) Plattenschaden mal neue, etwas größere Platten (4 TB statt 3 TB) eingebaut, aber nach diesem Plattentausch ging alles weiter seinen geregelten Gang.

Dieser Gang war allerdings in den letzten Monaten etwas holprig, denn oft mangelte es an Platz, sowohl auf dem NAS als auch (vor allem) auf den USB-Platten für das externe Backup. Auf das NAS laufen Backups des Homeservers (täglich, automatisch, inkrementiell mit jedem Monat einem neuen Vollbackup), des Desktops und zweier Laptops (manuell, üblicherweise wöchentlich). Und mit der Zeit wurden (vor allem auf dem Desktop, aber auch den Laptops) die Platten größer, die Datenmengen wuchsen und man musste den Platzbedarf etwas im Blick haben. Zuerst erforderten die externen Backups regelmäßige manuelle Eingriffe (Löschen aller vorigen Versionen, damit das neue Backup passt), was schon nervig genug ist; ein Backup von 2-3 TB über USB 2.0 kann schnell länger als 24 Stunden dauern, und wenn das Backup dann fehlschlägt, muss man der Software beim Löschen des angefangenen Backups und der noch auf der Platte befindlichen Vorversion(en) das Händchen halten und das Backup dann später neu starten. Das ist ein deutlich größerer Aufwand als “einmal pro Woche morgens die Platte abstöpseln, ins Büro mitnehmen und am Abend die aus dem Büro mitgebrachte andere Platte wieder anstöpseln” und führt daher dazu, dass das externe Backup eher so alle 4-6 Wochen anstatt wöchentlich erfolgte. Und erst das, dann aber tatsächlich auch der knapper werdende Platz auf dem NAS führten dazu, dass ich erst die Anzahl der inkrementiellen Backups heruntergesetzt habe und dann immer fauler mit den Backups wurde - auch weil diese gerade als Vollbackup mit Validierung so lange dauerten, dass morgens der Rechner nicht zur Verfügung stand, weil das über Nacht gestartete Backup noch nicht fertig war. (Und weil ich die verschlüsselte Platte mit privaten Daten vor dem Backup dismounte, damit der Container ordentlich gesichert wird, kann ich dann nicht richtig arbeiten.) So fanden dann auch die Sicherungen von Desktop und Laptop mehr monatlich - beim Laptop aufgrund der seltenen Nutzung eher quartalsweise - als wöchentlich statt. Alles sehr unbefriedigend.

Dann las ich Anfang Februar zufällig bei Isotopp einen Blogbeitrag über eine Erweiterung des Fileservers - weil der Nachwuchs eine größere Platte im Laptop hat und daher mehr Backupplatz benötigt wird. Da wurden mal eben zwei zusätzliche 10-TB-Platten als RAID eingebaut. Und nachdem ich das gelesen hatte, habe ich mich ernsthaft gefragt, warum ich nicht einfach schon vor Jahren schlicht größere Festplatten gekauft habe. Gut, ich habe keinen Platz, um sie dazuzustecken, ich müsste die Platten austauschen, aber das ist kein großes Problem, und es ist nicht so, dass ich mir das nicht leisten könnte. Und deutlich größere Platten würden das Platzproblem schlicht lösen; mir war gar nicht recht präsent, welche Plattengrößen jetzt üblich und erschwinglich sind, zumal ich im Desktop nicht viel Platz brauche. Kaum hatte ich mir das gedacht, erinnerte ich mich daran, dass mich neben dem Platzmangel auch die fehlende Leistung des NAS zunehmend störte; es dauerte alles lange, die CPU war immer ausgelastet, und der Weboberfläche konnte man beim Start einer App gemütlich zuschauen und mal schnell einen neuen Kaffee holen. Nach 9 Jahren durfte es auch da vielleicht mal etwas Neues sein.

Eigentlich wollte ich darüber in Ruhe nachdenken und mich dann am Wochenende entscheiden, aber die Sache ließ mir keine Ruhe - eine kurze Recherche ergab, dass man problemlos Platten mit 10 TB, 12 TB oder mehr bekommt, und auch die Auswahl bei der Vielzahl der auf der Website von Synology angebotenen Geräte fiel mit passenden Filtern und den angebotenen Assistenten leicht: mindestens zwei Platten sollten es sein, und Hot-Swap-fähig sollte das Gerät auch sein. Nach kurzer Bedenkzeit - es müssen nicht drei oder vier Platten sein; optisch gefällig wäre schon schön; und ich muss zwar nicht sparen, aber auch nicht verschwenden - fiel dann noch am selben Tag die Entscheidung für ein Synology DS220+ und zwei 12-TB-Platten von Western Digital. Am Folgetag entschloss ich mich dann in der Mittagspause, das Konzept des externen Backups auf USB-Platten fortzuführen und kaufte noch zwei 14-TB-USB-Platten von Western Digital dazu. Bis Freitag war dann auch alles da, und ich konnte abends mit der Installation beginnen (um am Wochenende die Daten umzukopieren).

Allerdings hatte ich die Rechnung ohne den Wirt gemacht: trotz vielem hin und her erkannte das NAS nur eine Festplatte. Und nachdem ich die Platten im laufenden Betrieb getauscht hatte, ging natürlich gar nichts mehr. Eine Neuinstallation mit vertauschten Platten schlug fehl; der dritte Versuch - wieder in der ursprünglichen Konfiguration - brachte auch wieder das ursprüngliche Ergebnis. Und wenn man aufmerksam lauschte, hörte man auch das typische Klicken einer Platte, die anzufahren versucht, aber nicht anläuft. Offenbar war eine der Platten “dead on arrival”. Das kann natürlich passieren, nervte mich aber einigermaßen - zumal der Samstagvormittag schon mit diversen Besorgungen gefüllt war. Aber es half ja nichts, und so schob ich noch einen Besuch bei der örtlichen Filiale des Computerhändlers meines Vertrauens ein und kaufte eine dritte 12-TB-Platte. Wieder zuhause setzte ich sie ein … und endlich lief alles so, wie es laufen sollte, und ich konnte mein neues NAS endlich einrichten.

Damit war ich sehr zufrieden: alles läuft so flott und flüssig, und es ist soviel Platz! Jetzt noch schnell ein letztes Backup des alten NAS auf die mobile Platte, das dann Überspielen, und dann ist alles fertig. Nur … passte das Backup natürlich nicht auf die USB-Platte. Wie immer. Also musste ich das Backup dann nach vielen Stunden abbrechen, die alten Versionen löschen und es dann neu starten. Und das dauerte. Und dauerte.

Datensicherungsaufgabe: USB-Sicherung 1

Sicherungsziel: usbshare1

Start: Mo, 7 Feb 2022 19:37:33

Dauer: 3 Day 2 Hour 11 Minute 3 Second

Glücklicherweise hatte ich bereits am Wochenende begonnen, die Daten einfach “manuell” umzukopieren. Beide NAS exportieren die entsprechenden Verzeichnisse als Netzlaufwerke, also per SMB, und so kann man im Prinzip schlicht alles über den Windows-Explorer von einem aufs andere Verzeichnis verschieben. Das ging ganz gut und war nach wenigen Stunden erledigt. Die unter einem anderen Account laufenden Dateien des Server-Backups ließen sich nicht auf diese Weise verschieben - Windows mäkelte, dass es nicht zwei Verbindungen unter verschiedenen Nutzerkennungen zum selben Gerät vornehmen könne, und ich hatte keine Lust, eine Lösung dafür zu suchen. Warum nicht einfach vom Server aus die Dateien umkopieren? Gesagt, getan … und nachdem SFTP/SCP dafür nicht das richtige Tool schien, habe ich mich auch da für SMB entschieden. Ein wenig Googeln führte zu folgender einfacher Lösung:

mkdir /mnt/nasalt

mkdir /mnt/nasneu

mount -t cifs -o user=serveruser //nasalt/home /mnt/nasalt

mount -t cifs -o user=serveruser,vers=2.0 //nasneu/home /mnt/nasneu

cp -av /mnt/nasalt/backups/* /mnt/nasneu/backups/

Auch das war binnen vergleichsweise kurzer Zeit erledigt.

Für duply und duplicity auf dem Server reichte die Änderung des Backupziels; ähnlich funktionierte das mit Acronis True Image für Desktop und Laptop, wobei dort nach der Änderung des Backup-Ziels das dort bereits vorhandene Backup noch eingebunden werden musste. Das nächste Backup machte dann einfach dort weiter, wo es auf dem alten NAS aufgehört hatte, und zumindest gefühlt ging es auch schneller.

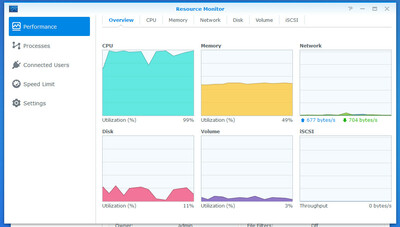

Danach habe ich direkt die erste externe Sicherung durchgeführt, und die ging nicht nur gefühlt schneller, sondern war - mit schnellerer CPU und USB 3 statt USB 2 - sehr, sehr deutlich spürbar flotter. Die beiden folgenden Screenshots zeigen u.a. die Dauerlast der CPU auf beiden Geräten im Vergleich; auf dem neuen NAS ist sie nicht einmal halb so hoch.

Nachdem mehr als drei Tage später (!) die Sicherung des alten NAS auf USB-Platte abgeschlossen war, habe ich von dieser Platte die letzten noch fehlenden Daten auf das neue NAS überspielt und dann das alte NAS (und die nicht mehr benötigten alten USB-Platten) neu initialisiert. Jetzt kann die alte Synology DS213 mal zeigen, was ein solches Gerät wirklich kann, statt nur als Fileserver für Backups zu dienen: sie soll nämlich in Zukunft an ihrem neuen Standort (bei der FRITZ!Box) als Medienserver für den Hausstand dienen, zunächst einmal für Musik, späer vielleicht auch für Fotos und Videos. Dafür konnte ich dann die NAS-Funktion in der FRITZ!Box deaktivieren und die dort angehängte externe USB-Platte anderweitig verwenden.

Bislang gefällt mir die neue Lösung, die sich auch in der Beschreibung auf meiner Website widerspiegelt, ausnehmend gut.

Titelbild © blickpixel - Fotolia

Kommentare

Ansicht der Kommentare: Linear | Verschachtelt

mitch am :

Dead on arrival kenne ich auch zur Genüge - zum Glück ist der letzte Fall schon länger her.

Ich habe mir inzwischen angewöhnt, jeden neuen Datenträger erstmal per smartctl zu testen - einmal short und danach einmal long.

Ich hatte noch nie einen einzelnen Massenspeicher größer als 2 TB (weder HDD noch SSD oder NVMe), ich will mir gar nicht ausmalen, wie lange ein Smart-Test auf 14 TB rotierendem Eisen dauert…

mitch am :

Oh: Der letzte Link im Artikel verweist auf die Staging-Umgebung und will einen Login.

Thomas Hochstein am :

Gah. Copy and paste braucht Sinn und Verstand.

Fixed, danke.